首篇NLP图神经网络综述来了! 127页文档让你全面了解这个领域( 二 )

3

图神经网络

在前一节中已经说明了用于不同 NLP 应用的各种传统的基于图的方法。作为一篇self-inclusive的文章,读者可以在本章节学习到GNN的基本基础和方法。本章节将GNNs分解成为graph filter和graph pooling两部分分别对图神经网络基础进行介绍。Graph filtering部分介绍了spatial-based, spectral-based, attention-based以及recurrent-based 图卷积模型。Graph pooling则分别介绍了flat pooling和hierarchical pooling.

4

NLP的图构建方法

在上一节中,本文讨论了给定图输入后 GNN 的基本基础和方法。不幸的是,对于大多数 NLP 任务,典型的输入是文本序列而不是图。因此,为了充分利用 GNN 的强大力量,如何从文本序列构建图输入就成为了一个要求很高的步骤。本节中重点介绍了两种主要的图构建方法,即静态图构建和动态图构建,用于在各种NLP任务中构建图结构化输入。

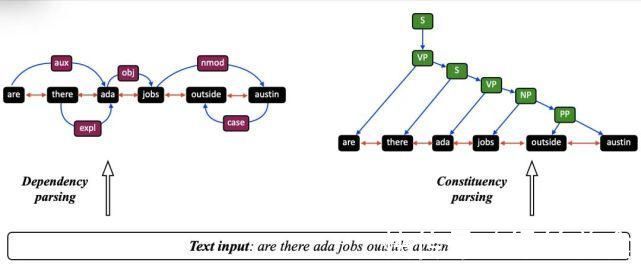

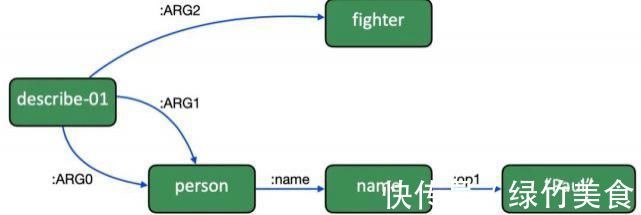

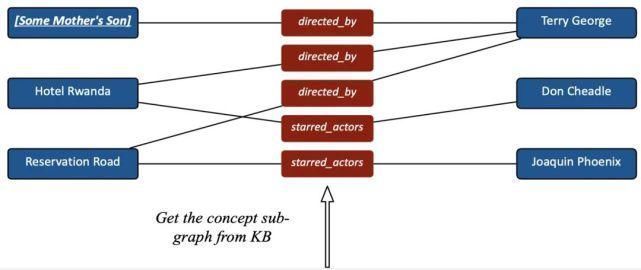

静态图部分介绍了dependency graph, constituency graph, AMR graph,knowledge graph, topic graph 等图构建方法, 如下图所示:

文章插图

(a)Depedency and constituency graph

文章插图

(b) AMR graph

文章插图

(c) Knowledge graph

文章插图

(d) Topic graph动态图部分介绍了依据similarity metric learning 和graph sparsity来构造隐式图结构的过程, 如下图所示:

5

NLP图表示学习

在上一节中,本文介绍了各种图构建方法,本节则将讨论对已构建好的图利用各种图表示学习技术进行学习和特征提取,用于各种 NLP 任务。图表示学习的目标是找到一种方法可以通过机器学习模型将图结构和其属性的信息合并到低维嵌入中。一般来讲,从原始文本数据构建的图要么是同构图,要么是异构图。因此,在第 5.1 节中,本文将讨论同构图的各种图表示学习方法,包括原始同构图的场景和一些从异构图转换的场景。在第 5.2 节中将讨论用于多关系图的基于 GNN 的方法。在第 5.3 节中,则将讨论用于处理异构图的基于GNN的方法。

6

基于编码器-解码器模型的图神经网络

这一章节我们讨论GNNs for NLP模型中的经典架构:编码器-解码器。传统的NLP模型也多采用该架构,例如Seq2Seq模型。许多研究工作都在开发基于 GNN 的编码器-解码器框架,包括 Graph-to-Tree 和 Graph-to-Graph 模型。本节首先介绍了典型的 Seq2Seq 模型,然后讨论针对各种 NLP 任务的各种基于图的编码器-解码器模型。

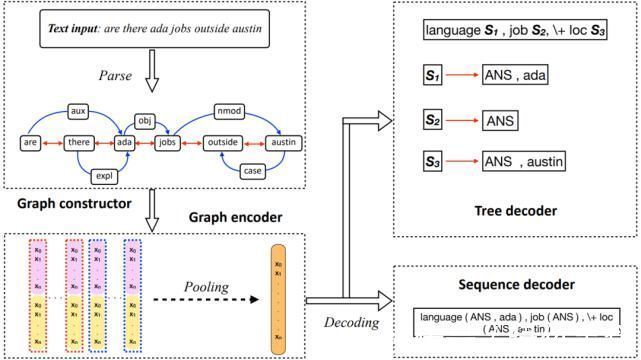

下图就是基于图的编码器-解码器模型的整体架构示例,其中包含了Graph2Seq和Graph2Tree模型,输入和输出来自JOBS640数据集。下图展示了所有编码器-解码器结构的细节图。图中像S1,S2这样的节点代表子树节点,新的分支从这生成。

文章插图

7应用

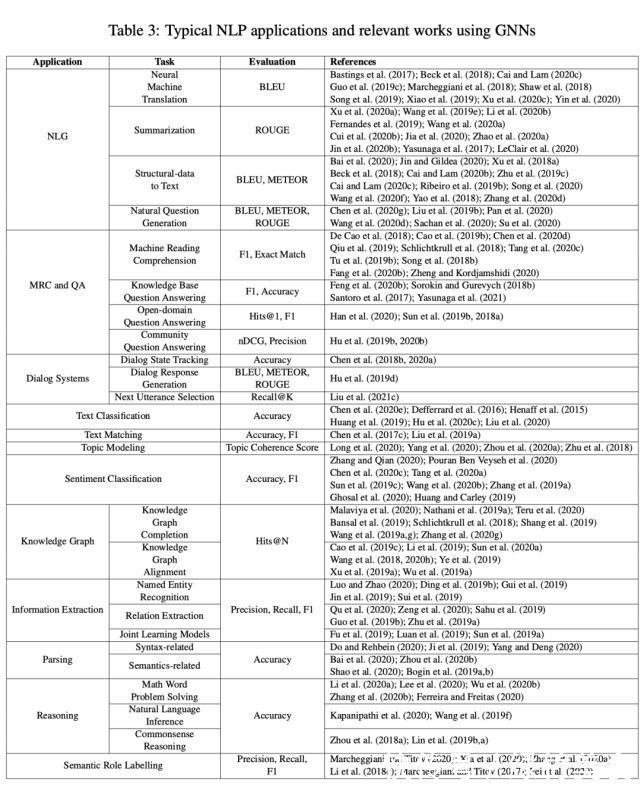

本节讨论使用 GNN 的各种典型 NLP 应用,包括自然语言生成、机器阅读理解、问答、对话系统、文本分类、文本匹配、主题建模、情感分类、知识图谱、信息提取、语义和句法解析、推理和语义角色标记。对于每个应用场景,作者介绍了其背景,主要技术细节,及其子任务和评估指标。整个内容概括如下图所示。

文章插图

8总的挑战(General Challenges)和未来方向

- 三星|试图挽回中国市场,国际大厂不断调价,从高端机皇跌到传统旗舰价

- 设计师|UI设计岗位薪资怎么样

- m都是大片!微软 Skype 支持将必应 Bing 图片设为通话虚拟背景

- gtx1060|GTX1060上古神器?

- 风情万种的倪妮

- 观光巴士|无人驾驶观光巴士走进湖滨

- 上海图书馆东馆东方网记者包永婷1月16日报道:1月15日下午|上海图书馆东馆内部啥样?跟着读者公测先睹为快

- 图灵奖|中国科技团队创历史,360打破行业垄断,登顶世界最强人工智能榜

- 图灵奖|“世界最强”人工智能榜单,“中国代表队”力压群雄登顶榜首

- 上门|快递上门的“蜀道难”