A/B测试增长实战( 三 )

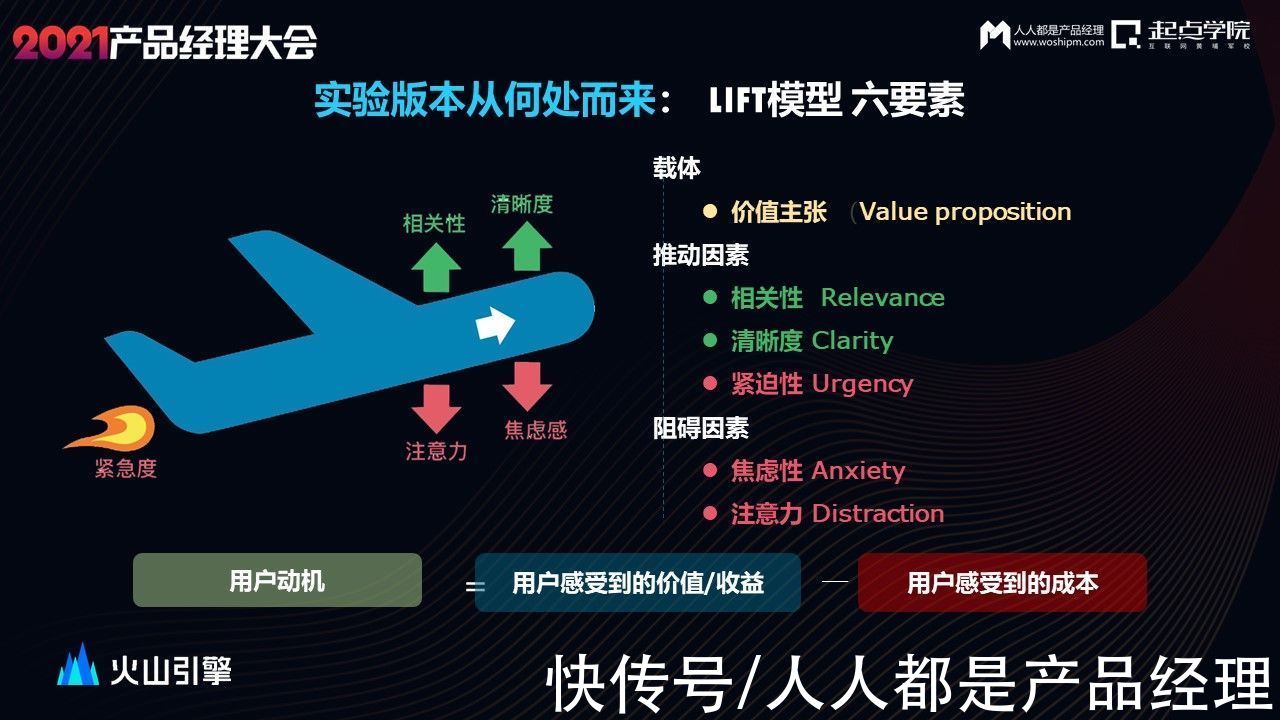

我们提出了LIFT模型,并且从中总结了一个公式:

用户动机=用户感受到的价值/收益–用户感受到的成本

文章插图

我们要做的就是放大收益,缩小成本。

还是以电商产品为例,价值主张就是希望买到物美价廉的商品。如何放大这个价值呢?如果我是一个美妆爱好者,那就需要把营销的重点放在美妆品类,并且让我清楚地第一眼就知道这是一个关于美妆的营销活动。

以上就是需要提升的因素,而焦虑性和注意力都是需要降低的因素。

比如焦虑性,说一个大家不一定注意到的焦虑感来源,如果UI页面的色彩对比过于明显,对比度过高,从心理学层面来说会对用户造成一定程度的视觉焦虑。通过优化UI页面,可以减少焦虑和分散注意力的情况。

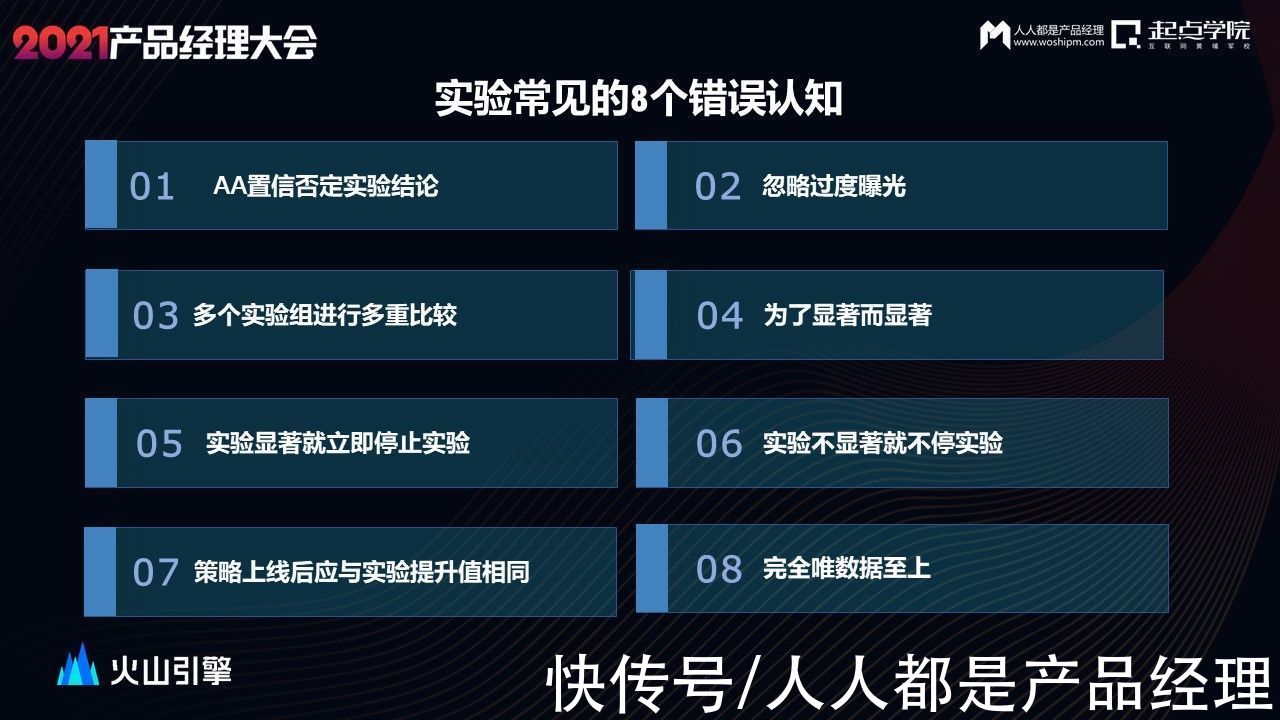

字节做了80w+实验,从前期的A/B小白到后期输出成熟的A/B测试平台,我们也是亲身踩坑,总结出了以下经验,实验常见的8个错误认知:

文章插图

有些同学为了校验分流服务是否正常喜欢开aa实验,但是在检验假设的过程中,我们会犯第一类错误——我的策略没有用,但实验结果显示我的策略有用。

在95%的置信水平下这类错误出现的概率是5%,即我们开100次AA实验,然后观测某个指标,可能会有5次得到显著的结果。这是由于不可避免的抽样误差所导致的。发生AA置信的情况属于正常现象,A/B测试平台会保证分流和统计服务的可靠性,请你尽管大胆假设,小心实验。

另外,实验不显著就不停止实验。理论上任何一点差异只要样本足够多,都能检测出差距,A/B实验中,无论A策略与B策略多么相像,他们终归是不一样的。理论上来说,只要样本足够多(比如无穷多时),最后实验结果都会形成统计显著。但这种显著有意义吗?比如我的实验开启了整整10年,新策略使指标提升0.001%。

那这样的实验意义大吗?

文章插图

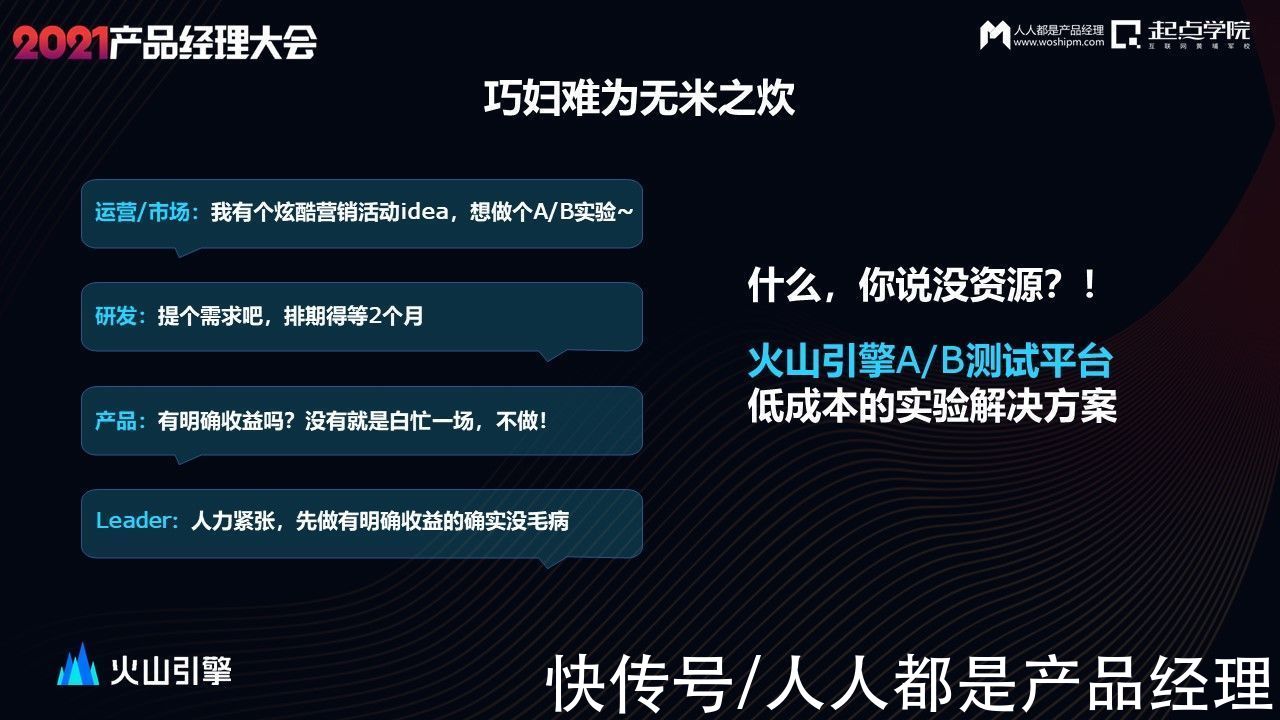

既然A/B测试这么有效,但是公司开发资源紧缺,这可怎么办?

字节早期A/B测试也是没有产品化平台的,后续为了降低我们自己做实验的成本,开发了火山引擎A/B测试平台,一个低成本的实验解决方案。

文章插图

比如运营人常用的落地页实验,将不同样式的落地页链接放上去,就能对比看出不同落地页的转化效果。

可视化实验,如果只是想改动页面的中文案、图片、颜色等,可以通过可视化实验调整UI页面。

push实验,这也是运营最常用的实验。测试推送的时间、推送的文案、推送的策略等,找到最佳的转化方案。

这还不够,用技术和算法实现了实验智能化,希望能够彻底把人力从琐碎的工作中解脱出来。

因此我们推出了动态调优的智能实验,其原理就是多臂老虎机。

文章插图

这种实验无需A/B测试,根据用户实时反馈智能分配,并保障收益最大化,可以对大部分运营实验实现智能化,运营推送文案赛马、落地页动态优选、广告投放策略优选、活动页面样式调整呢可以 做MVT多变量组合智能优选,优势非常明显。

我用一个游戏的例子介绍智能化实验是怎么回事。

为了保持用户粘性,游戏一般有完善的用户激励体系,这款游戏app在运营初期设计了一套发元宝来激活用户的方案。早中晚发放三次元宝,每次会发push通知用户进行召回。

运营精心设计挑出了最满意四组文案。

- 测试|解码自动驾驶商业化进阶的亦庄样本

- CPU|性价比不二之选!i5-12400网游测试:已看见锐龙7 5800X尾灯

- AMD 3D V-Cache 技术测试:延迟略增,但处理器性能更强

- 分发量|YY直播:2021年合作公会总数增长24%,百度导入流量3亿/天

- 太空旅客|华为视频App新版本测试:支持边下边播

- 36氪|启中教育:如何实现店铺爆发式增长

- 社区矫正中心|邯山区司法局推进“智慧社区矫正中心”建设,打造实战平台,提升矫正

- 年终篇:兴趣电商与国货增长的两大价值体系

- 腾讯云|实现TO B销售规模化持续增长三步法 | 腾讯云原生加速器

- 微信|微信发布 8.0.18 测试版,加入信息清单功能