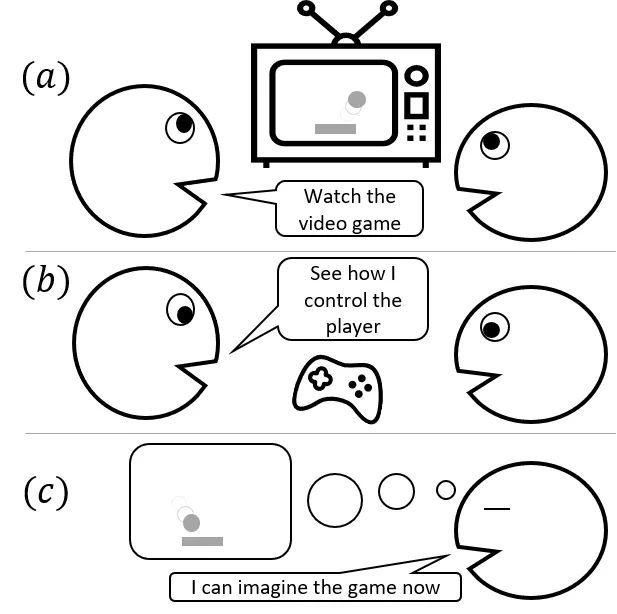

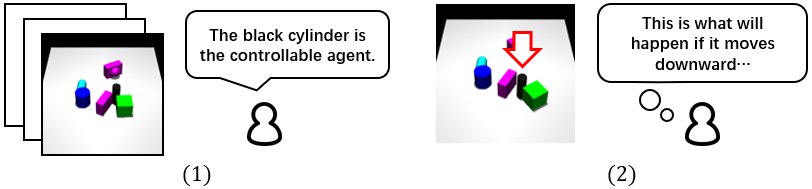

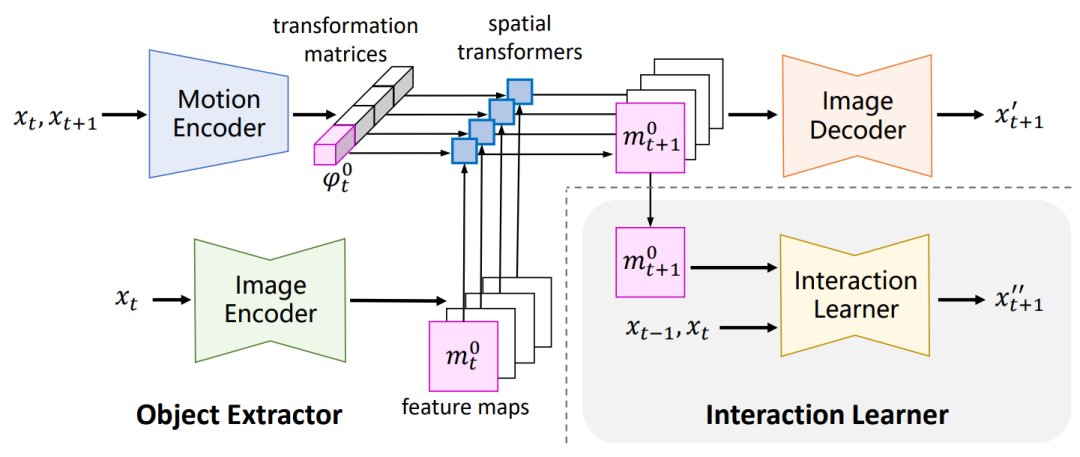

导读:本文是机器人领域顶级会议 IROS 2021入选论文《基于无监督学习环境模型的机器人运动控制(DMotion: Robotic Visuomotor Control with Unsupervised Forward Model Learned from Videos)》的解读。该论文由北京大学前沿计算研究中心董豪课题组主导完成。项目主页:https://hyperplane-lab.github.io/dmotion/ 论文地址:https://arxiv.org/abs/2103.04301 在机器人控制、基于模型的强化学习领域,学习环境的模型是重要的问题。现有方法学习环境模型通常需要大量从环境中采集的带标签的数据,如智能体动作、物体位置、运动的真实标注,在许多现实场景的应用中有局限性。 而认知科学的研究认为,人类婴儿能够仅通过视觉观察,建立物理世界的模型、进行预测。无监督地建立物理模型能够帮助人类与环境交互、操控工具来完成各种任务。如图1的例子所示:玩家 B 通过观察玩家 A 操作,学习如何玩一个游戏。为学会玩游戏,玩家 B 需要建立游戏的模型,知道键盘上的操作(动作标注)与画面中主角动作的对应关系、采取某个动作会如何影响游戏的状态。现实中,玩家 B 大部分时间都会只关注游戏画面,而不去观察玩家 A 操作键盘的每一个动作。对游戏模型的理解,例如哪个是主角、主角和游戏环境是怎么互动的,大多是通过观看游戏画面完成的;观察键盘的操作仅仅是为了知道如何去控制主角的每个动作。 受此启发,我们研究如何利用缺少动作标注的视频数据学会环境模型,来实现基于模型的机器人运动控制。如下图所示,我们提出的方法(DMotion)首先从无监督的视频中解耦智能体的运动、学习物体之间的交互规律;最后通过少量的带有动作标注的数据,DMotion 建立动作标注到智能体运动的映射,学会环境模型。 图2. DMotion学习“机器人推物体”环境的过程 图3. DMotion的训练框架,由Object Extractor和Interaction Learner组合,进行端到端的学习 问题定义:环境是马尔可夫决策过程