文章图片

文章图片

文章图片

文章图片

编辑:LRS

【新智元导读】「图像生成质量」和「隐私保护」 , 二者不可得兼 。

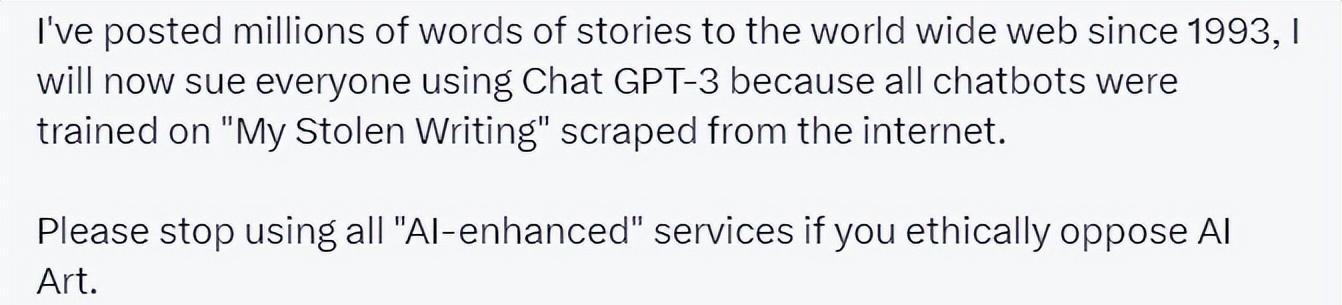

去年 , 图像生成模型大火 , 在一场大众艺术狂欢后 , 接踵而来的还有版权问题 。

类似DALL-E 2 Imagen和Stable Diffusion等深度学习模型的训练都是在上亿的数据上进行训练的 ,

根本无法摆脱训练集的影响 , 但是否某些生成的图像就完全来自于训练集?如果生成图像与原图十分类似的话 , 其版权又归谁所有?

最近来自谷歌、Deepmind、苏黎世联邦理工学院等多所知名大学和企业的研究人员们联合发表了一篇论文 , 他们发现

扩散模型确实可以记住训练集中的样本 , 并在生成过程中进行复现 。

在这项工作中 , 研究人员展示了扩散模型如何在其训练数据中记忆单个图像 , 并在生成时将其重新复现出来 。

文中提出一个

生成和过滤(generate-and-filter)的pipeline , 从最先进的模型中提取了一千多个训练实例 , 覆盖范围包含人物的照片、商标的公司标志等等 。 并且还在不同的环境中训练了数百个扩散模型 , 以分析不同的建模和数据决定如何影响隐私 。

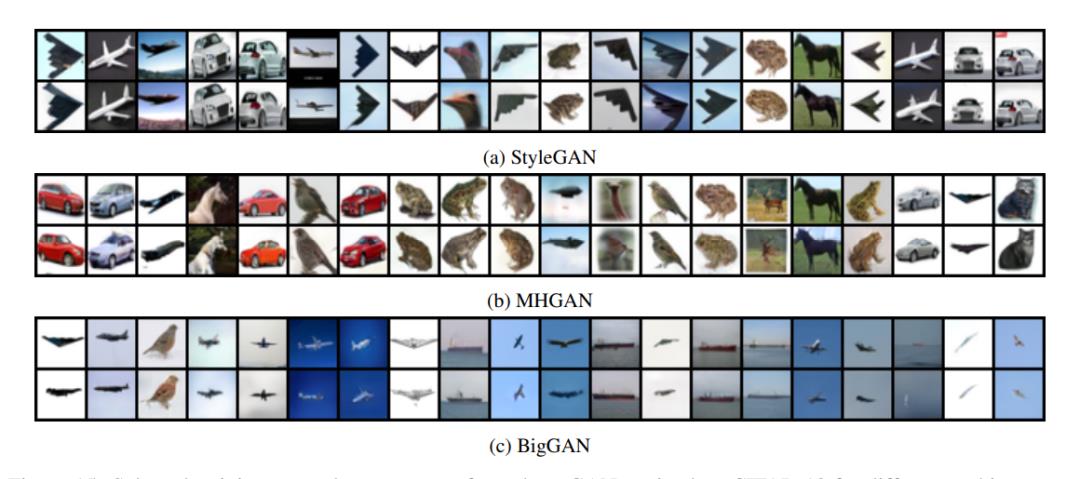

总的来说 , 实验结果显示 , 扩散模型对训练集的隐私保护比之前的生成模型(如GANs)要差得多 。

记了 , 但记得不多

去噪扩散模型(denoising diffusion model)是近期兴起的新型生成式神经网络 , 通过迭代去噪的过程从训练分布中生成图像 , 比之前常用的GAN或VAE模型生成效果更好 , 并且更容易扩展模型和控制图像生成 , 所以也迅速成为了各种高分辨率图像生成的主流方法 。

尤其是OpenAI发布DALL-E 2之后 , 扩散模型迅速火爆了整个AI生成领域 。

生成式扩散模型的吸引力源于其合成表面上与训练集中的任何东西都不同的新图像的能力 , 事实上 , 过去的大规模训练工作「没有发现过拟合的问题」 , 而

隐私敏感领域(privacy sensitive domain)的研究人员甚至提出 , 扩散模型可以通过合成图像来「保护真实图像的隐私」 。

不过这些工作都依赖于一个假设:

即扩散模型不会记忆并再次生成训练数据 , 否则就会违反隐私保证 , 并引起诸多关于模型泛化和数字伪造(digital forgery)的问题 。

但事实果真如此吗?

要想判断生成的图像是否来自于训练集 , 首先需要定义

什么是「记忆」(memorization) 。

之前的相关工作主要集中在文本语言模型上 , 如果模型能够逐字从训练集中恢复一个逐字记录的序列 , 那么这个序列就被称为「提取」和「记忆」了;但因为这项工作是基于高分辨率的图像 , 所以逐字逐句匹配的记忆定义并不适合 。

下面是研究人员定义的一个基于图像相似性度量的记忆 。

如果一个生成的图像x , 并且与训练集中多个样本之间的距离(distance)小于给定阈值 , 那么该样本就被视为从训练集中得到的 , 即Eidetic Memorization.

然后 , 文中设计了一个两阶段的

数据抽取攻击(data extraction attack)方法:

- realme|真我GT Neo5配备16+1TB!三星万元机还是8+256

- 加盟商上市前夜大逃亡,KK集团烧钱维系的701家门店还值200亿吗

- Google|为何大疆不做油动无人机?可以用一句话来总结

- 光刻机|一中国企业曝接近式光刻机研发进展,但离EUV光刻机还差太远

- 苹果|美国欲全面断供华为,我国为什么还不制裁苹果?

- chatgpt|当国人还在研究怎么复现ChatGPT时,GPT-4已经就要到来

- 苹果|元宇宙烧了 137 亿美元,还得 Facebook 救 Meta

- 能量都要买?网友开小号给蚂蚁森林浇水:被封号居然还喊冤

- 一加科技|一加发布会新品盘点:最强骁龙8+,还有职业赛事认证的游戏耳机

- 隐形眼镜|百度、谷歌接连官宣,还有多少ChatGPT竞品在路上?